Av alla internetens läskiga krafter är det förmågan att lura det intetanande vara det mest skrämmande. Clickbait, fotoshoppade bilder och falska nyheter är några av de värsta gärningsmännen, men de senaste åren har också sett ökningen av ett nytt potentiellt farligt verktyg som kallas deepfake artificiell intelligens (AI).

Begreppet deepfake avser förfalskade, datorgenererade video och ljud som är svåra att skilja från äkta, oförändrat innehåll. Det är att filma vad Photoshop är för bilder.

Hur fungerar deepfake AI?

Verktyget förlitar sig på vad som kallas generativa adversarialnätverk (GAN), en teknik som uppfanns 2014 av Ian Goodfellow, en doktorsexamen. student som nu arbetar på Apple, rapporterade Popular Mechanics.

GAN-algoritmen innefattar två separata AI: er, en som genererar innehåll - låt oss säga, foton av människor - och en motståndare som försöker gissa om bilderna är verkliga eller falska, enligt Vox. Den genererande AI börjar med nästan ingen aning om hur människor ser ut, vilket innebär att dess partner lätt kan skilja riktiga bilder från falska bilder. Men med tiden blir varje typ av AI successivt bättre och så småningom börjar den genererande AI producera innehåll som ser perfekt livsliknande ut.

Deepfake-exempel

GAN är imponerande verktyg och används inte alltid för skadliga ändamål. År 2018 såldes en GAN-genererad målning som imiterar den holländska "Old Master" -stilen av konstnärer som 1600-talets Rembrandt van Rijn på Christies auktionshus för otroliga 432 500 $.

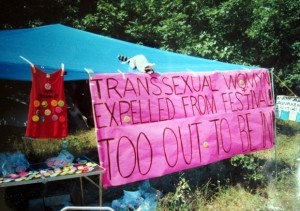

Samma år ökade deepfakes till utbredd framträdande, främst genom en Reddit-användare som fick namnet "deepfakes", rapporterade Vice. GAN-tekniken användes ofta för att placera ansikten från kända kändisar - inklusive Gal Gadot, Maisie Williams och Taylor Swift - på kropparna av pornografiska filmskådespelerskor.

Andra GAN har lärt sig att ta en enda bild av en person och skapa ganska realistiska alternativa foton eller videor av den personen. År 2019 kunde ett djupfusk generera läskiga men realistiska filmer av Mona Lisa som pratar, rör sig och ler i olika positioner.

Deepfakes kan också ändra ljudinnehåll. Som rapporterats av The Verge tidigare i år kan tekniken dela upp nya ord i en video om en person som pratar, vilket får det att se ut som att de sa något som de aldrig tänkte.

Det enkla att använda det nya verktyget har potentiellt skrämmande konsekvenser. Om någon, var som helst kan göra realistiska filmer som visar en kändis eller politiker som talar, rör sig och säger ord de aldrig sade, tvingas tittarna att vara mer försiktiga med innehåll på internet. Som ett exempel, lyssna bara på president Obama som varnar mot en "utmattad" dystopisk framtid i den här videon från Buzzfeed, skapad med djupfake av filmskaparen Jordan Peele.