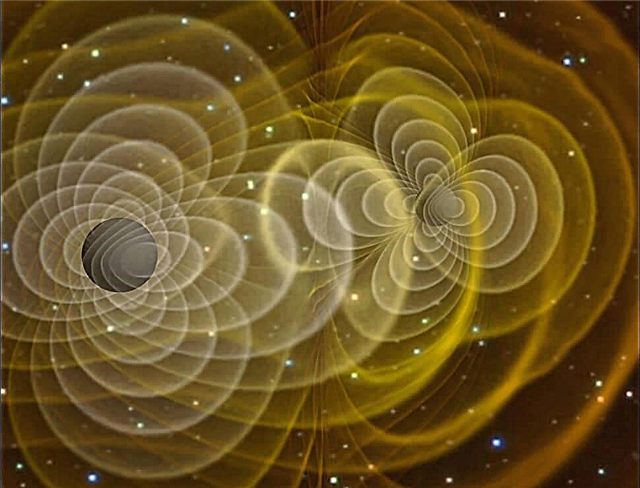

Gravitationsvågor är tydligen djävuliskt svåra saker att modellera med Einstein-fältekvationer, eftersom de är mycket dynamiska och icke-symmetriska. Traditionellt sett var det enda sättet att komma nära att förutsäga de sannolika effekterna av tyngdvågorna att uppskatta de nödvändiga parametrarna för Einstein-ekvationen genom att anta att föremål som orsakar tyngdvågorna inte genererade starka tyngdfält själva - och inte heller rörde sig med hastigheter någonstans nära ljusets hastighet.

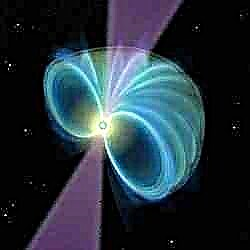

Problemet är att de mest troliga kandidatobjekten som kan generera detekterbara gravitationsvågor - nära binära neutronstjärnor och sammanslagning av svarta hål - har exakt dessa egenskaper. De är mycket kompakta, mycket massiva kroppar som ofta rör sig med relativistiska (dvs. nära ljusets hastighet) hastigheter.

Är det inte konstigt då att den "guesstimate" -inriktningen som beskrivs ovan verkligen fungerar briljant för att förutsäga beteendet hos nära massiva binärer och sammanfoga svarta hål. Därför en ny artikel med titeln: Om den orimliga effektiviteten av post-Newtonian tillnärmning i gravitationsfysiken.

Så för det första har ingen ännu upptäckt gravitationvågor. Men även 1916 ansåg Einstein deras existens troligt och visade matematiskt att gravitationsstrålning borde uppstå när du byter ut en sfärisk massa med en roterande hantel med samma massa som på grund av dess geometri kommer att generera dynamiska ebb- och flödeseffekter på rymden när det roterar.

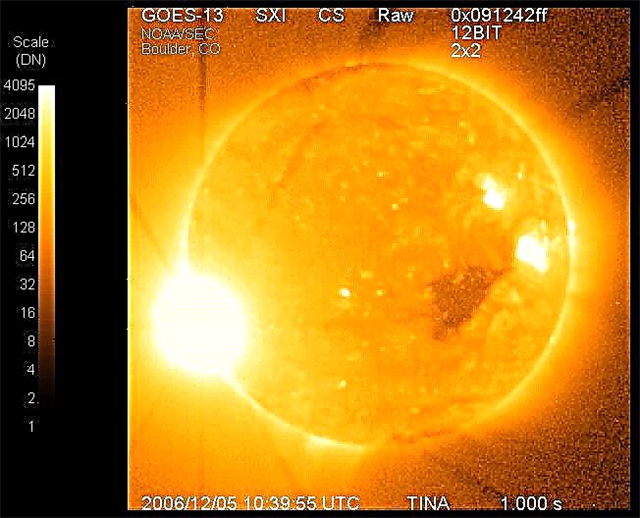

För att testa Einsteins teori är det nödvändigt att designa mycket känslig detekteringsutrustning - och hittills har alla sådana försök misslyckats. Ytterligare förhoppningar vilar nu till stor del på Laser Interferometer Space Antenna (LISA), som inte förväntas lanseras före 2025.

Men såväl som känslig detekteringsutrustning som LISA, måste du också beräkna vilken typ av fenomen och vilken typ av data som skulle representera definitivt bevis på en tyngdkraftsvåg - som är där all teori och matematik som krävs för att bestämma dessa förväntat värden är avgörande.

Ursprungligen arbetade teoretikerna ut post-Newtonsk (dvs. Einstein-eran) approximation (dvs guesstimate) för ett roterande binärt system - även om det erkändes att denna approximation bara skulle fungera effektivt för ett system med låg massa, låg hastighet - där alla komplicerade relativistiska och tidvattenseffekter, som uppstår till följd av de binära objekternas självtyngd och hastigheter själva, kunde ignoreras.

Sedan kom den numeriska relativitetens era där tillkomsten av superdatorer gjorde det möjligt att faktiskt modellera all dynamik i nära massiva binära rörelser med relativistiska hastigheter, precis som hur superdatorer kan modellera väldigt dynamiska vädersystem på jorden.

Överraskande, eller om du vill oresonligt, de beräknade värdena från den numeriska relativiteten var nästan identiska med de som beräknades med den förmodade kroppsliga post-Newtonian approximationen. Den efter-Newtonianska tillnärmningsstrategin är inte tänkt att fungera i dessa situationer.

Allt som författarna sitter kvar med är möjligheten att gravitationsrödförskjutning gör att processer nära mycket massiva föremål verkar långsammare och gravitativt "svagare" för en extern observatör än de egentligen är. Det kan - typ av, typ av - förklara den orimliga effektiviteten ... men bara den slags.

Vidare läsning: Will, C. Om den orimliga effektiviteten av den postnewtoniska tillnärmningen i gravitationsfysiken.